上一篇

光学透视式增强现实系统

- 行业动态

- 2025-04-22

- 4

光学透视式增强现实系统

光学透视式增强现实(Optical See-Through Augmented Reality, OSTAR)系统是一种通过光学技术将虚拟信息与真实世界场景融合的技术方案,其核心特点是用户直接通过光学器件观察真实环境,同时接收由系统生成的虚拟信息(如文字、图像、3D模型等),实现虚实结合的视觉体验。

系统核心原理

-

光学透视机制

- 用户通过透明显示屏或光学组合器(如半反半透镜、光波导)直接观察真实环境。

- 虚拟信息通过投影或微型显示器(如OLED、LCOS)生成,并利用光学路径叠加到用户视野中。

- 虚实光线在人眼中融合,形成增强后的视觉效果。

空间定位与跟踪

- 通过摄像头、惯性传感器(IMU)、GPS等设备实时捕捉用户位置、姿态和环境信息。

- 结合SLAM(即时定位与地图构建)或标记识别技术,确保虚拟内容与真实场景的精准对齐。

系统关键组件与功能

| 组件 | 功能描述 |

|---|---|

| 微型显示器 | 生成高分辨率虚拟图像(如OLED屏),尺寸小、亮度高。 |

| 光学组合器 | 将虚拟图像与真实光线融合,常见方案包括半透半反镜、自由曲面棱镜、光波导等。 |

| 感知模块 | 摄像头(RGB/深度相机)、IMU、ToF传感器等,用于环境感知与用户动作追踪。 |

| 计算处理单元 | 运行空间定位算法、图像渲染引擎,并协调虚实信息同步。 |

| 校准与标定系统 | 确保光学器件的参数匹配,减少畸变和色差。 |

关键技术解析

显示技术

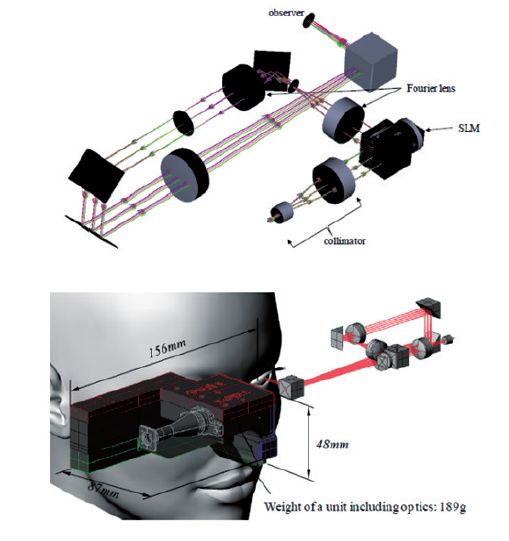

- 微型投影仪:通过光机系统将虚拟画面投影到视网膜或组合器。

- 微显示技术:如LCOS、Micro-OLED,直接输出高亮度、高对比度的虚拟画面。

光学设计

- 视场角(FOV):需覆盖人眼自然视野(约120°),避免遮挡真实环境。

- 亮度与对比度需适应不同光照环境,通常要求亮度>2000尼特。

- 光路优化:通过非球面透镜或自由曲面设计减少像差和色散。

空间注册精度

- 依赖计算机视觉算法(如特征点匹配、点云对齐)实现毫米级定位误差。

- 动态环境下需实时补偿头部移动和视角变化。

典型应用场景

- 工业维护

通过AR标注设备故障点,叠加维修步骤指导,提升检修效率。

- 医疗手术

在患者体内投影3D血管/器官模型,辅助医生精准操作。

- 军事训练

模拟战场环境(如敌情标记、地形数据),增强士兵战术决策能力。

问题与解答

问题1:光学透视式AR与视频透视式AR(Video See-Through, VST)的核心区别是什么?

解答:

- 光学透视式(OST):直接通过光学器件观察真实环境,无摄像头介入,延迟低,但虚拟内容受限于光学设计。

- 视频透视式(VST):先用摄像头采集真实环境画面,再将虚拟内容叠加后显示在屏幕上,优点是可后期处理图像(如增强夜景),但存在传感器延迟和画质损失。

问题2:光学透视式AR系统的主要技术挑战有哪些?

解答:

- 视场角与亮度矛盾:扩大FOV会导致虚拟画面亮度下降,需平衡光学效率。

- 动态校准难度:用户头部移动时,需实时调整光学路径以保持虚实对齐。

- 设备重量与功耗:高性能组件(如微型投影仪、传感器)会增加终端设备的负载