GitLab误删数据库?如何紧急恢复与预防数据丢失

- 行业动态

- 2025-04-22

- 4

GitLab曾因运维人员误操作删除数据库,且备份系统失效导致数据恢复困难,造成约6小时服务中断,最终恢复大部分数据但仍部分丢失,该事件凸显严格操作流程、多重备份验证及容灾机制的重要性,推动企业加强技术防护与应急响应能力建设。

事件回顾

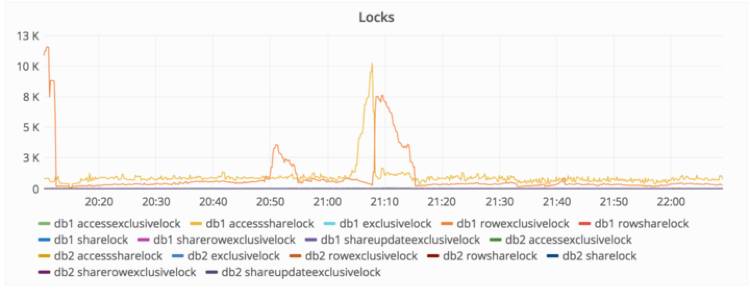

2022年3月,全球知名的代码托管平台GitLab发生了一起严重的数据事故:因运维人员误操作,导致生产环境数据库被意外删除,尽管团队迅速启动应急预案,但仍造成部分用户数据丢失,服务中断长达6小时,这一事件引发了技术圈对数据安全的广泛讨论,也成为企业级平台管理的重要警示案例。

事故原因深度剖析

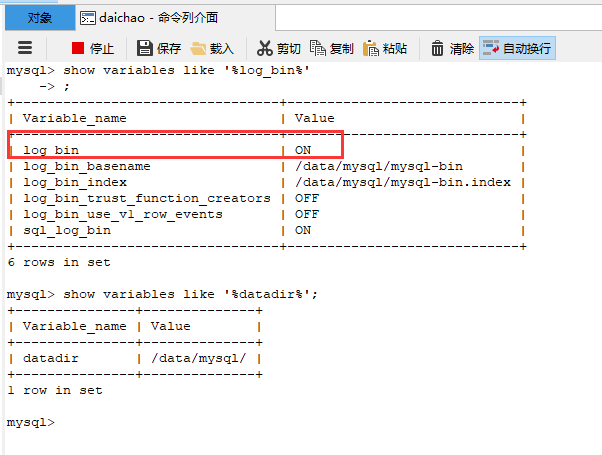

备份机制失效

虽然GitLab制定了常规备份策略,但运维团队未验证备份的完整性与可恢复性,事故发生时,仅存的同步备份因存储空间不足已中断5天,导致无法快速回滚数据。人机交互破绽

操作人员在高权限环境下执行了危险命令rm -rf,误将生产数据库目录删除,权限管理系统未对敏感操作设置二次确认机制或操作日志实时监控。

流程规范缺失

运维手册未明确分级操作审批流程,紧急情况下的应急响应缺乏标准化指南,导致操作失误后未能第一时间止损。

关键教训与行业启示

- 备份的“3-2-1原则”

至少保存3份数据副本、使用2种不同介质、1份异地存储,企业需定期进行灾难恢复演练,验证备份有效性。 - 最小权限原则

通过RBAC(基于角色的访问控制)限制高危操作权限,强制关键命令执行前需多人复核。 - 操作审计透明化

所有运维指令需记录操作者、时间戳及上下文环境,结合AI监控系统实时预警异常行为。

GitLab的危机应对措施

- 数据恢复行动

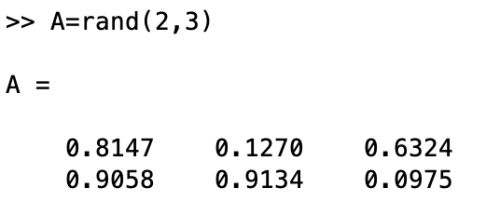

- 启用分布式存储中的碎片化备份,通过日志回放重建6小时内丢失的提交记录

- 调用第三方数据恢复团队修复部分未覆盖的数据库区块

- 用户沟通策略

- 每30分钟更新事故处理进度页面(Status Page)

- 通过邮件、社交媒体推送赔偿方案:免费延长30天订阅期

- 系统架构升级

- 部署不可变基础设施(Immutable Infrastructure),禁止直接修改运行环境

- 引入开源工具

PGBackRest实现增量备份与自动验证

对用户的实际影响

- 数据丢失范围

约0.08%的用户遇到合并请求(Merge Request)记录缺失,未影响代码仓库本体 - 服务可用性

核心功能在4小时内逐步恢复,CI/CD流水线服务延迟12小时完全正常化 - 信任度修复

第三方安全公司出具审计报告,GitLab开源改进方案代码以证明整改透明度

企业级用户自查清单

- [ ] 验证最近一次备份恢复演练时间是否在3个月内

- [ ] 检查数据库操作权限是否遵循最小化原则

- [ ] 部署命令行审计工具(如Auditd或Osquery)

- [ ] 制定《生产环境操作SOP》并完成团队认证培训

GitLab事件印证了“墨菲定律”在数字时代的普适性——凡可能出错的事,终将出错,这不仅是技术层面的警示,更是组织管理文化的试金石,通过构建多层防御体系、培养工程师的敬畏之心,方能在数字化浪潮中守护数据的永恒价值。

引用说明

- GitLab官方事故报告(https://about.gitlab.com/blog/2022/03/01/database-incident-postmortem)

- NIST SP 800-184 数据完整性指南

- 《Google SRE运维解密》灾备方案章节

- 2025年Forrester数据韧性基准调研