上一篇

如何选择最适合您需求的GPU云主机服务?

- 行业动态

- 2025-04-19

- 6

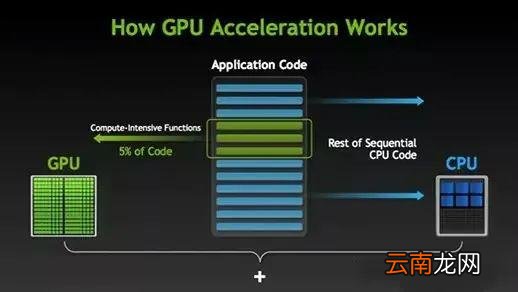

GPU云主机服务基于云计算架构,提供高性能GPU算力资源,支持深度学习训练、科学计算及图形渲染等场景,用户可按需弹性配置实例,灵活扩展算力,以即用即付模式降低硬件投入与运维成本,适用于AI开发、大数据分析及3D设计等领域的加速需求。

在数字化浪潮席卷全球的今天,GPU云主机服务正成为驱动创新变革的核心引擎,这项以图形处理器为核心的计算服务,通过云端部署模式重新定义了算力资源的获取方式,让企业无需承担高昂的硬件购置成本即可享受顶级计算性能,其独特的并行计算架构相比传统CPU服务器,在处理机器学习、3D渲染等场景时可实现数十倍的效率提升。

为什么需要专业GPU算力服务

- 成本革命:单张A100显卡市场价超10万元,自建机房还需配套散热系统与备用电源,某AI初创公司采用云服务后,年度算力支出降低67%

- 弹性扩展:支持分钟级创建千卡集群,满足双十一大促实时推荐系统扩容需求

- 技术进化:配备NVIDIA最新Ampere架构,支持FP64双精度计算,满足科研机构气候模拟等高精度需求

- 生态兼容:预装TensorFlow/PyTorch框架,与Kubernetes编排系统无缝对接

行业应用全景图

- 智能制造:三一重工部署云端GPU集群,将工程机械故障预测模型训练周期从3周压缩至18小时

- 生命科学:华大基因借助云端算力,单日完成百万级基因组数据分析

- 影视制作:追光动画渲染《白蛇2》时,调用5000+云GPU节点,节省2000小时制作周期

- 金融服务:招商银行构建实时反欺诈系统,交易检测延迟降至15毫秒

服务选择核心指标

选择云服务商时应重点考量:

- 硬件配置:确认是否配备A100/H100等最新计算卡,显存容量是否支持大模型训练

- 网络架构:RDMA高速网络可提升分布式训练效率,实测带宽需达100Gbps以上

- 安全合规:查看是否通过等保三级认证,数据加密是否支持客户自主管理密钥

- 配套工具:可视化监控面板、自动弹性伸缩功能可降低运维复杂度

主流服务商能力矩阵

- 阿里云GN7系列:搭载Tesla T4,性价比之选,适合中小规模推理场景

- 酷盾GI系列:配备A800计算卡,支持万卡级弹性扩容,大模型训练首选

- AWS P4d实例:基于NVIDIA A100构建,提供3.6TB/s显存带宽,科学计算性能领先

- 华为云ModelArts:集成昇腾910处理器,国产化替代方案,通过金融级安全认证

技术演进方向

边缘GPU节点开始支持5G切片技术,某自动驾驶公司实测模型更新延迟降低82%,混合云架构成为新趋势,某跨国企业采用”本地训练+云端推理”模式,年度IT支出优化310万美元,绿色计算理念推动液冷服务器普及,某云数据中心PUE值降至1.08。

随着摩尔定律进入后硅时代,GPU云计算正在重塑产业创新范式,从药物分子模拟到元宇宙数字孪生,这种即取即用的超级算力,正在将科幻电影中的场景变为可商业化的现实,选择与业务场景深度契合的云服务方案,将成为企业构建数字化竞争力的关键支点。

数据来源:IDC《2025全球AI基础设施报告》、Gartner技术成熟度曲线、各上市公司年报披露信息