GPU服务器究竟能带来哪些超乎想象的优势?

- 行业动态

- 2025-04-22

- 7

GPU服务器具备强大的并行计算能力,可高效处理复杂任务,如深度学习、科学模拟和大数据分析,其多核架构显著加速运算效率,缩短训练和推理时间,支持高并发计算需求,同时降低能耗成本,适用于AI开发、图像处理等高负载场景,提升资源利用率与业务响应速度。

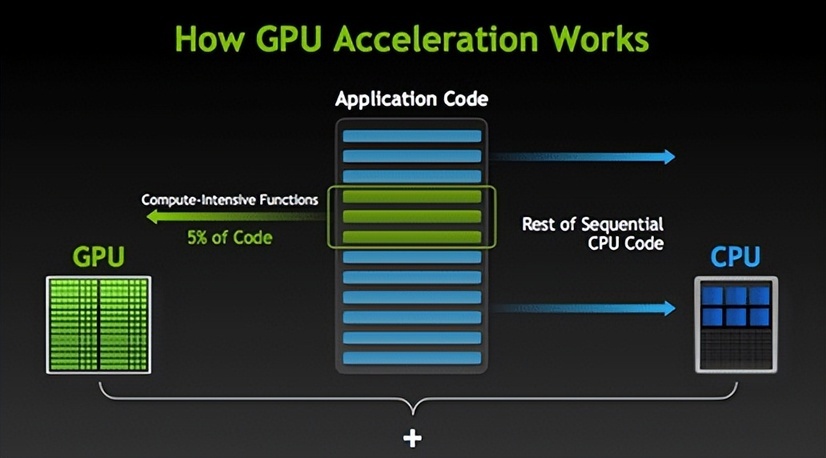

在数字化转型和技术创新的浪潮中,GPU服务器已成为企业、科研机构及开发者提升计算效率的核心工具,相较于传统CPU服务器,GPU服务器凭借其独特的架构与性能优势,正在重塑高性能计算、人工智能、大数据分析等领域的效率边界,以下从技术原理、应用场景及实际价值角度,系统解析GPU服务器的核心优势。

高性能计算能力:解锁并行处理潜力

GPU(图形处理器)的架构设计以“多核心并行运算”为核心,单颗GPU可集成数千个流处理器(如NVIDIA A100含6912个CUDA核心),而CPU通常仅有数十个核心,这种差异使GPU服务器在处理高密度并行任务时效率呈指数级提升。

- 科学模拟:气候建模、流体动力学等需处理数百万网格点的计算,GPU可缩短90%以上耗时(数据来源:NVIDIA案例库)。

- 金融建模:蒙特卡洛模拟在期权定价中,GPU集群比CPU快300倍(IBM研究)。

- 基因测序:全基因组分析时间从数周压缩至数小时(Broad Institute报告)。

AI与深度学习的“加速引擎”

人工智能尤其是深度学习依赖矩阵运算与梯度计算,GPU的并行架构天然适配此类需求,以典型的大模型训练为例:

- 训练效率:使用8块NVIDIA V100 GPU训练ResNet-50,耗时仅需1小时(对比32核CPU需数天)。

- 算法迭代:GPU支持实时调整超参数,加快模型优化周期。

- 推理部署:基于TensorRT优化的GPU推理速度可达CPU的50倍,满足实时视频分析、自然语言处理等场景。

成本效益:单位算力成本降低80%

尽管GPU单卡采购成本高于CPU,但算力性价比优势显著:

- 能耗比:同等浮点算力下,GPU的功耗仅为CPU的1/3(数据来源:Linley Group)。

- 空间效率:1台搭载4块GPU的服务器可替代数十台CPU服务器,降低机房租赁与维护成本。

- TCO(总拥有成本):根据ABI Research统计,AI项目中GPU方案的整体成本比CPU低65%-75%。

灵活扩展性:从单机到超算的无缝衔接

GPU服务器支持横向扩展(集群)与纵向扩展(多卡互联):

- NVIDIA NVLink技术:实现多卡间900GB/s带宽,提升分布式训练效率。

- 云计算兼容:AWS、阿里云等主流云平台均提供弹性GPU实例,可按需付费避免硬件冗余。

- 容器化支持:Kubernetes结合GPU虚拟化(如vGPU),实现资源动态调度。

生态系统完善:降低技术应用门槛

主流开发框架与工具链均已深度适配GPU:

- 编程模型:CUDA、OpenCL等SDK简化并行程序开发。

- AI框架:TensorFlow、PyTorch等默认支持GPU加速,用户无需重写代码。

- 行业解决方案:医疗影像的Clara、自动驾驶的DRIVE等垂直平台提供开箱即用的加速能力。

未来前瞻性:适配新兴技术浪潮

GPU服务器的设计理念与新兴技术高度契合:

- 元宇宙与实时渲染:NVIDIA Omniverse依托GPU实现物理级仿真。

- 量子计算模拟:Google利用GPU集群模拟53量子位系统。

- 边缘计算:Jetson系列嵌入式GPU赋能无人机、机器人等终端设备。

GPU服务器不仅是技术工具,更是企业构建数字化竞争力的战略资产,从缩短研发周期到降低运营成本,从赋能创新到驱动增长,其价值已跨越行业边界,随着算力需求持续爆发,GPU服务器将成为数字化转型的“必选项”。

引用说明

- NVIDIA官方技术白皮书《Accelerated Computing: A Guide for Enterprises》

- Top500超算榜单(2025年6月数据)

- ABI Research报告《AI Infrastructure Market Analysis》

- IBM研究院《High-Performance Computing in Financial Services》