Hadoop服务器性能优化难题如何破解

- 行业动态

- 2025-04-16

- 2

在大数据时代,Hadoop服务器已成为企业处理海量数据的核心技术之一,无论是电商平台的用户行为分析,还是金融机构的风险预测,Hadoop都能通过分布式存储与计算能力提供高效解决方案,本文将深入解析Hadoop服务器的核心特性、应用场景及部署实践,助您全面掌握这一技术。

Hadoop服务器是什么?

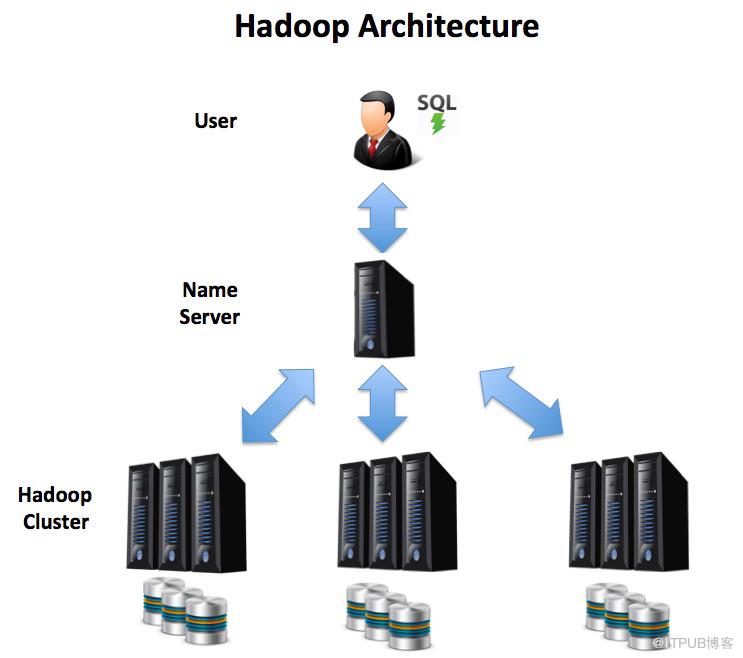

Hadoop是由Apache基金会开发的开源框架,专为分布式存储与计算设计,其核心思想是将大规模数据集分割为多个小块,分散存储于不同服务器节点,并通过并行处理机制加速运算,这一架构使Hadoop能够处理PB级数据,且具备高容错性,即便部分节点故障,系统仍可正常运行。

三大核心组件

HDFS(Hadoop Distributed File System)

分布式文件系统,将数据拆分为固定大小的块(默认128MB),并在多台服务器上存储副本,确保数据安全性与访问效率。MapReduce

编程模型,通过“映射(Map)”和“归约(Reduce)”两阶段处理数据,Map阶段并行处理数据块,Reduce阶段汇总结果,适合批量计算场景。YARN(Yet Another Resource Negotiator)

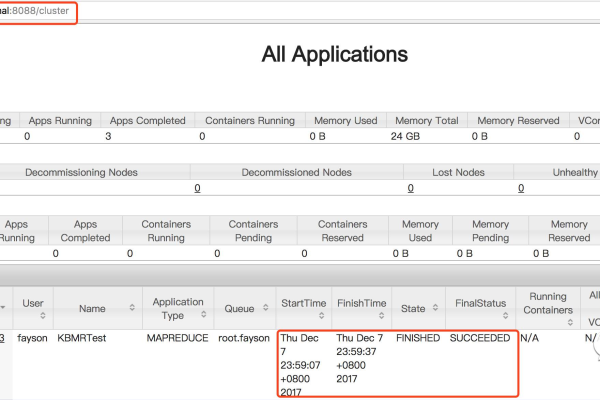

资源管理平台,负责集群资源的分配与任务调度,支持多种计算框架(如Spark、Flink)在Hadoop上运行。

Hadoop服务器的核心优势

高容错性

数据默认存储3份副本,单节点故障不影响整体服务。横向扩展能力

通过增加廉价服务器即可扩容,成本仅为传统数据库的1/10(据IBM研究)。

灵活的数据处理

支持结构化、半结构化和非结构化数据,兼容日志、图片、视频等多种格式。生态系统丰富性

可与Hive(数据仓库)、HBase(NoSQL数据库)、Spark(实时计算)等工具无缝集成。

典型应用场景

电商用户行为分析

通过分析TB级点击流数据,优化推荐算法,提升转化率,某头部电商利用Hadoop将用户分群耗时从24小时缩短至2小时。金融风控建模

银行整合多源数据(交易记录、征信报告等),训练反欺诈模型,检测准确率提升40%。物联网设备监控

制造业企业实时采集万台设备传感器数据,预测故障并减少停机损失。医疗影像存储

医院使用HDFS存储千万级CT/MRI影像,并通过分布式检索提升调阅效率。

部署与管理实践

硬件规划

建议采用多节点架构(至少3台服务器),配置SSD硬盘提升I/O性能,主节点需更高内存(64GB+),数据节点建议10Gbps网络环境。环境搭建

推荐使用Cloudera或Hortonworks发行版,集成可视化监控工具(如Ambari),简化集群管理。性能调优

- 调整HDFS块大小(根据数据特征选择256MB或512MB)

- 优化MapReduce任务并行度(mapreduce.job.maps参数)

- 启用数据压缩(Snappy或LZ4算法降低存储开销)

- 安全加固

- 启用Kerberos身份认证

- 配置HDFS访问控制列表(ACL)

- 定期审计日志(通过Apache Ranger)

挑战与应对策略

技术复杂度高

解决方案:采用托管服务(如AWS EMR、阿里云Hadoop)降低运维成本。实时处理能力不足

解决方案:结合Spark Streaming或Flink实现流式计算。数据治理难题

解决方案:引入Apache Atlas构建元数据管理体系。

未来演进方向

云原生融合

容器化部署(Kubernetes + Hadoop)提升资源利用率,混合云架构成为趋势(据Gartner 2025报告)。AI增强分析

Hadoop与TensorFlow/PyTorch集成,支持分布式模型训练。边缘计算协同

在边缘节点部署轻量级Hadoop模块,实现近数据源处理。

参考资料

- Apache Hadoop官方文档:https://hadoop.apache.org

- 《Hadoop权威指南》(Tom White著,O’Reilly出版)

- 国际数据公司(IDC)《2025全球大数据市场预测》

- Cloudera技术白皮书《Best Practices for Hadoop Deployment》

- 谷歌学术论文《MapReduce: Simplified Data Processing on Large Clusters》