上一篇

GPU服务器深度学习环境配置指南,从零搭建高效计算平台5步搞定

- 行业动态

- 2025-04-15

- 6

GPU服务器深度学习环境需安装显卡驱动、CUDA工具包及cuDNN加速库,配置Python环境并安装TensorFlow/PyTorch等框架,建议使用conda或docker管理依赖,通过nvcc、nvidia-smi验证软硬件兼容性,优化并行计算与显存分配效率。

为什么需要专业的GPU服务器环境配置?

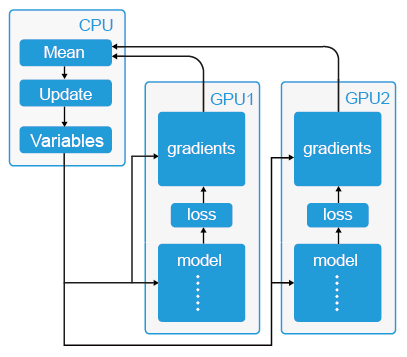

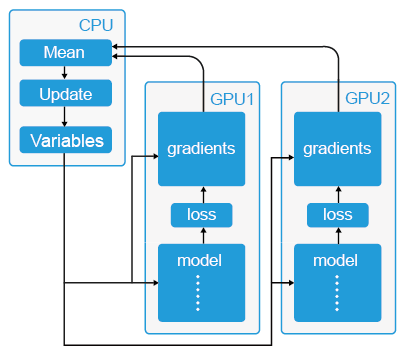

深度学习模型训练对计算资源要求极高,GPU凭借其并行计算能力成为加速训练的核心硬件,环境配置的细微偏差可能导致性能损耗、兼容性问题甚至训练失败,本文提供一套经过验证的标准化流程,帮助用户快速搭建稳定高效的深度学习环境。

硬件选择与系统准备

GPU选型建议

- NVIDIA Tesla系列(如A100、V100):专为数据中心设计,支持多卡并行与高速互联,适合大规模训练。

- NVIDIA RTX消费级显卡(如RTX 4090/3090):性价比高,适合中小规模实验。

- 显存要求:至少16GB,大模型训练推荐24GB以上。

操作系统推荐

- Ubuntu 22.04 LTS:兼容性强,社区支持完善。

- CentOS 7/8:企业级稳定性,但需手动处理驱动依赖。

# 更新系统(Ubuntu示例) sudo apt update && sudo apt upgrade -y # 安装基础依赖 sudo apt install build-essential cmake git -y

NVIDIA驱动与CUDA安装

禁用默认驱动

sudo nano /etc/modprobe.d/blacklist-nouveau.conf # 添加以下内容: blacklist nouveau options nouveau modeset=0 sudo update-initramfs -u

安装GPU驱动

# 添加官方仓库(以Ubuntu为例) sudo add-apt-repository ppa:graphics-drivers/ppa sudo apt update # 查询推荐驱动版本 ubuntu-drivers devices # 安装推荐版本(例如535) sudo apt install nvidia-driver-535 -y # 重启后验证 nvidia-smi

CUDA Toolkit安装

- 根据框架需求选择版本(例如PyTorch 2.1需CUDA 11.8+):

wget https://developer.download.nvidia.com/compute/cuda/12.2.2/local_installers/cuda_12.2.2_535.104.05_linux.run sudo sh cuda_12.2.2_535.104.05_linux.run # 配置环境变量 echo 'export PATH=/usr/local/cuda/bin:$PATH' >> ~/.bashrc echo 'export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc source ~/.bashrc

- 根据框架需求选择版本(例如PyTorch 2.1需CUDA 11.8+):

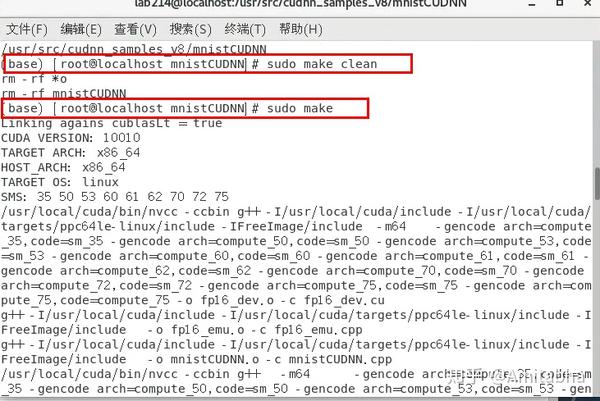

cuDNN与深度学习框架配置

cuDNN安装

- 从NVIDIA开发者网站下载与CUDA匹配的版本:

# 解压后复制文件(示例为CUDA 12.x) sudo cp cudnn-linux-x86_64-8.9.6.50_cuda12-archive/include/cudnn*.h /usr/local/cuda/include sudo cp cudnn-linux-x86_64-8.9.6.50_cuda12-archive/lib/libcudnn* /usr/local/cuda/lib64 sudo chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

- 从NVIDIA开发者网站下载与CUDA匹配的版本:

Python环境管理(推荐Anaconda)

wget https://repo.anaconda.com/archive/Anaconda3-2025.09-0-Linux-x86_64.sh bash Anaconda3-2025.09-0-Linux-x86_64.sh # 创建独立环境 conda create -n dl_env python=3.10 conda activate dl_env

安装深度学习框架

# PyTorch(指定CUDA版本) pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 # TensorFlow pip install tensorflow[and-cuda]==2.13.0 # 验证GPU识别 python -c "import torch; print(torch.cuda.is_available())"

容器化部署(可选)

使用Docker可快速复制环境:

安装Docker Engine与NVIDIA Container Toolkit

curl -fsSL https://get.docker.com | sh sudo systemctl enable docker # 配置NVIDIA支持 distribution=$(. /etc/os-release;echo $ID$VERSION_ID) curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add - curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list sudo apt update && sudo apt install nvidia-container-toolkit -y sudo systemctl restart docker

拉取预置镜像

docker run --gpus all -it nvcr.io/nvidia/pytorch:23.10-py3

常见问题排查

- 驱动冲突:使用

sudo apt purge nvidia*彻底清理旧驱动。 - CUDA版本不匹配:通过

conda install cuda -c nvidia指定版本。 - 显存不足:监控工具推荐

gpustat或nvitop。

权威引用来源

- NVIDIA官方文档:https://docs.nvidia.com/cuda/

- PyTorch安装指南:https://pytorch.org/get-started/locally/

- TensorFlow GPU支持:https://www.tensorflow.org/install/gpu

- Docker容器配置:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/index.html

通过以上步骤,可建立符合工业标准的GPU计算环境,建议定期检查驱动更新,并通过nvcc --version与nvidia-smi监控硬件状态。