上一篇

bp神经网络用什么构建

- 行业动态

- 2025-04-11

- 8

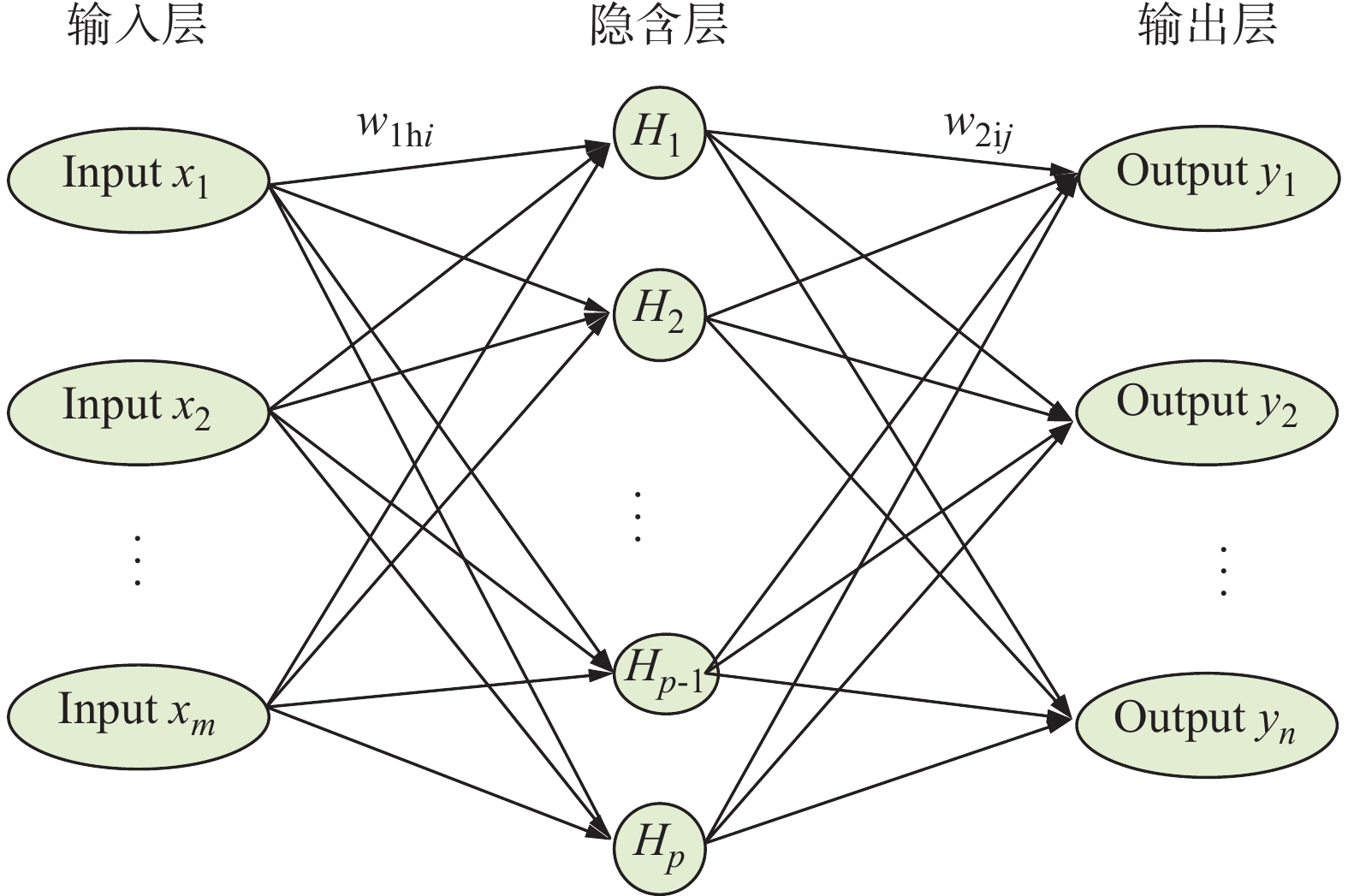

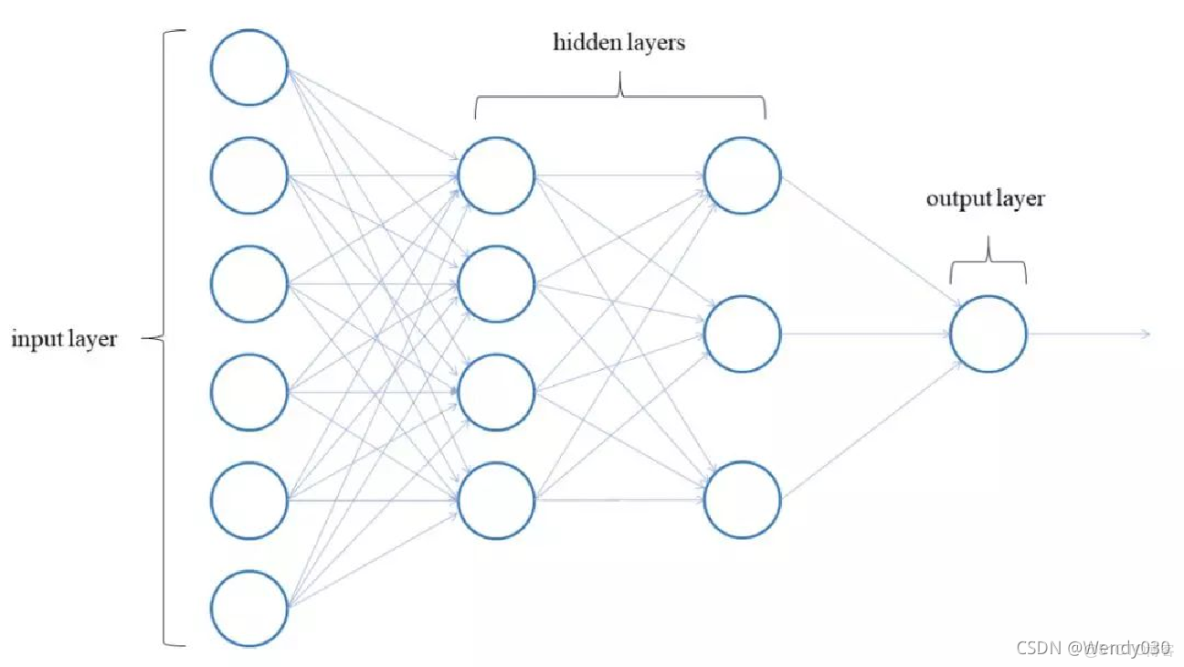

BP神经网络由输入层、隐藏层和输出层构成,每层包含多个神经元节点,其核心组件包括权重矩阵、偏置项、激活函数(如Sigmoid或ReLU)以及误差反向传播算法,通过前向传播计算输出值,再基于损失函数反向调整参数,结合梯度下降等优化方法实现模型训练和参数更新。

BP神经网络用什么构建?

BP神经网络(误差反向传播神经网络)是深度学习领域的基础模型之一,广泛应用于分类、回归等任务,其构建需要从结构设计、核心算法、工具框架等多个维度综合考虑,以下从技术实现角度详细拆解BP神经网络的构建要素。

基本结构组件

神经元层(Neural Layers)

- 输入层(Input Layer):接收原始数据(如像素值、传感器信号),节点数由数据特征维度决定。

- 隐藏层(Hidden Layers):通过非线性激活函数(如Sigmoid、ReLU)提取特征,层数和节点数需根据任务复杂度调整。

- 输出层(Output Layer):输出预测结果,节点数与任务类型相关(如分类任务对应类别数,回归任务为1个节点)。

连接权重与偏置(Weights & Biases)

- 权重(( W_{ij} )):连接不同层神经元的参数,初始值通常随机生成(如Xavier初始化)。

- 偏置(( b_j )):为每个神经元引入偏移量,增强模型拟合能力。

核心算法组件

前向传播(Forward Propagation)

数据从输入层逐层传递至输出层,计算每层输出:

[

z^{(l)} = W^{(l)} cdot a^{(l-1)} + b^{(l)}, quad a^{(l)} = f(z^{(l)})

]

( f )为激活函数,( a^{(l)} )为第( l )层的输出。

损失函数(Loss Function)

衡量模型预测值与真实值的差异,常见选择:- 均方误差(MSE):适用于回归任务,( L = frac{1}{N}sum_{i=1}^N (y_i – hat{y}_i)^2 )。

- 交叉熵损失(Cross-Entropy):适用于分类任务,( L = -sum_{i=1}^N y_i log(hat{y}_i) )。

反向传播(Backpropagation)

基于链式法则计算梯度,逐层更新参数:- 计算输出层误差:( delta^{(L)} = nabla_a L odot f'(z^{(L)}) )。

- 反向传递误差至隐藏层:( delta^{(l)} = (W^{(l+1)})^T delta^{(l+1)} odot f'(z^{(l)}) )。

- 更新权重与偏置:

[

W{ij} := W{ij} – eta cdot delta_j^{(l)} a_i^{(l-1)}, quad b_j := b_j – eta cdot delta_j^{(l)}

]

( eta ) 为学习率。

优化算法

- 随机梯度下降(SGD):基础优化方法,按批次更新参数。

- 动量法(Momentum):引入历史梯度加速收敛。

- Adam:自适应调整学习率,平衡梯度一阶矩和二阶矩。

构建工具与框架

编程语言与库

- Python:主流语言,生态丰富。

- TensorFlow/PyTorch:提供自动微分、GPU加速支持。

- NumPy:手动实现BP神经网络的基础数学运算库。

开发流程示例(以Python为例)

import tensorflow as tf model = tf.keras.Sequential([ tf.keras.layers.Dense(64, activation='relu', input_shape=(784,)), # 隐藏层 tf.keras.layers.Dense(10, activation='softmax') # 输出层 ]) model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) model.fit(X_train, y_train, epochs=10, batch_size=32)

关键注意事项

数据预处理

- 归一化(Normalization):将输入数据缩放到[0,1]或[-1,1]区间,避免梯度爆炸。

- 独热编码(One-Hot Encoding):分类任务中处理标签数据。

超参数调优

- 学习率(( eta )):过高导致震荡,过低收敛慢,可尝试自适应方法(如Adam)。

- 批量大小(Batch Size):影响训练速度和梯度稳定性,通常选32-256。

- 正则化(Regularization):L2正则化或Dropout防止过拟合。

模型评估

- 划分验证集(Validation Set)监控泛化性能。

- 使用混淆矩阵、ROC曲线等指标分析分类效果。

常见问题与解决方案

- 梯度消失/爆炸:改用ReLU激活函数,或使用残差连接(ResNet)。

- 过拟合:增加训练数据,应用L2正则化或早停法(Early Stopping)。

- 训练速度慢:启用GPU加速,减少网络层数或节点数。

引用说明 参考了以下权威资料:

- Ian Goodfellow等,《深度学习》(Deep Learning),MIT Press,2016。

- 周志华,《机器学习》,清华大学出版社,2016。

- TensorFlow官方文档(https://www.tensorflow.org/)。

- PyTorch官方教程(https://pytorch.org/tutorials/)。