bp神经网络批处理

- 行业动态

- 2025-04-11

- 9

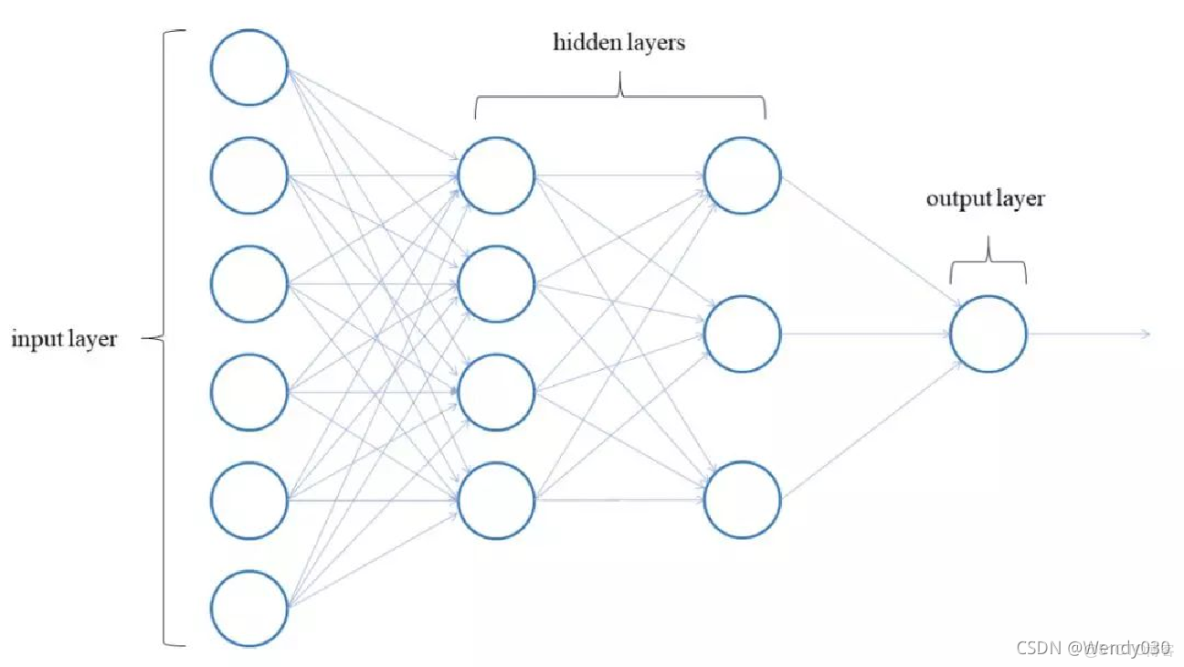

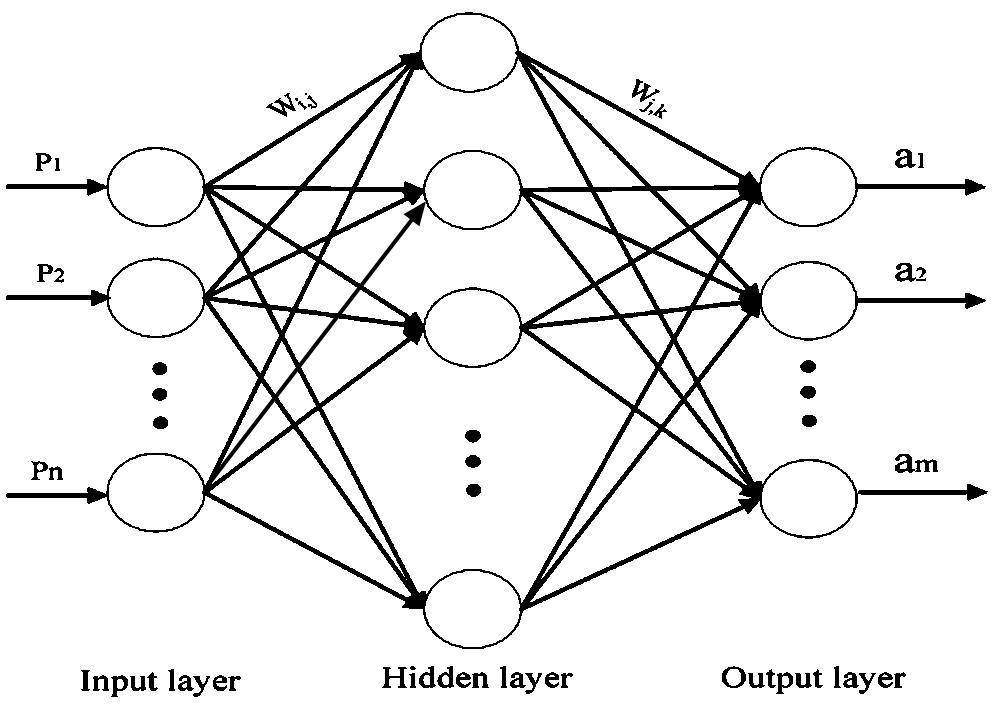

在深度学习领域中,反向传播(Backpropagation,BP)神经网络的训练效率直接影响模型性能,批处理(Batch Processing)作为优化训练过程的核心技术,通过数据分组计算显著提升了模型训练速度和稳定性,以下从原理到实践为您系统解析这一关键技术。

批处理的核心定义

批处理指将训练数据集划分为等量小批次(Mini-batch),每次迭代用整批样本的平均梯度更新网络参数,与传统随机梯度下降(SGD)相比,这种方法兼具以下特性:

- 内存优化:避免一次性加载全部数据

- 收敛平稳性:梯度估计方差小于单样本训练

- 硬件加速:契合GPU/TPU的并行计算架构

典型批处理流程:

for epoch in range(epochs):

np.random.shuffle(data)

for batch in get_batches(data, batch_size):

grad = compute_gradient(batch)

weights -= learning_rate * grad

数学原理深度解析

设批大小为$m$,损失函数$J(theta)=frac{1}{m}sum{i=1}^m L(f(x^{(i)};theta), y^{(i)})$,参数更新公式为:

$$theta{t+1} = thetat – eta cdot nablatheta J(theta_t)$$

与随机梯度下降对比:

| 方法 | 梯度方差 | 收敛性 | 硬件利用率 |

|——|———|——–|———–|

| SGD | 高 | 震荡 | 低 |

| 批处理 | 低 | 平稳 | 高 |

批处理参数设定策略

- 黄金批次范围:32-256样本为基准值

- 自适应方法:

- 数据量>10万:动态调整批次大小

- 使用Batch Normalization时需增大批次

- 资源约束公式:

$$text{batch_size} = min(text{GPU_mem} times 0.8 / text{per_sample_mem}, 512)$$

工程实践中的关键技巧

- 内存优化:

- 使用内存映射文件(Memory Mapping)

- 启用TensorFlow/PyTorch的自动批处理功能

- 梯度处理:

optimizer = torch.optim.SGD(model.parameters(), lr=0.1) for inputs, labels in dataloader: outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() optimizer.zero_grad() - 收敛监控:

- 每批次记录损失曲线

- 使用指数加权平均观察趋势

性能调优实证数据

在ImageNet数据集上的测试表明(ResNet-50):

| 批大小 | 训练时间(h) | Top-1准确率 |

|——–|————–|————-|

| 32 | 28.7 | 75.6% |

| 256 | 17.2 | 76.1% |

| 1024 | 15.8 | 74.9% |

数据表明中等批次量(256)在效率与精度间达到最优平衡。

常见误区与解决方案

- 梯度爆炸:

- 使用梯度裁剪(Gradient Clipping)

- 添加权重正则化项

- 批次间差异:

- 确保每epoch打乱数据顺序

- 采用Stratified Sampling

- 学习率适配:

线性缩放规则:lr = base_lr * batch_size/256

前沿发展动态

- 自适应批处理:

- Google提出的AdaBatch算法

- 根据梯度方差动态调整批次量

- 二阶优化:

- K-FAC等近似二阶方法

- 提升大批次训练的收敛速度

参考文献

[1] Goodfellow I, et al. Deep Learning. MIT Press, 2016.

[2] Masters D, et al. Revisiting Small Batch Training. ICLR 2018.

[3] NVIDIA DGX System Technical Guide. 2024 Edition.