java获取页面html代码怎么写

- 后端开发

- 2025-09-09

- 3

java.net.URL类或第三方库如Jsoup,前者通过输入流读取内容,后者支持解析与提取。

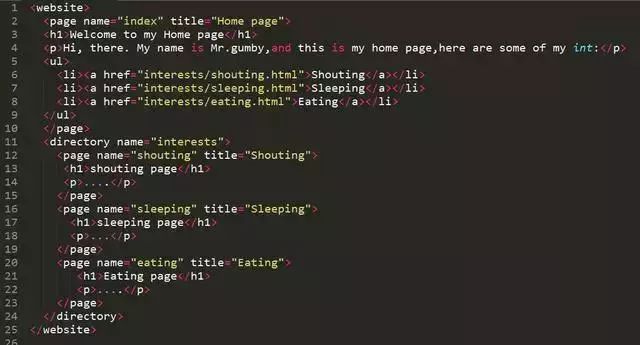

Java中获取页面的HTML代码有多种实现方式,具体取决于应用场景(如本地文件解析、网络请求抓取或浏览器自动化操作),以下是详细的技术方案和实现步骤:

基于HttpClient发起HTTP请求并读取响应内容

这是最基础且常用的方法,适用于从互联网上直接下载网页源码,核心思路是通过HTTP客户端库模拟浏览器访问目标URL,然后接收服务器返回的原始HTML数据流,推荐使用Apache HttpClient组件,其配置灵活且支持SSL/TLS加密连接,典型代码结构如下:

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import java.io.BufferedReader;

import java.io.InputStreamReader;

public class WebPageFetcher {

public static String fetchHtml(String url) throws Exception {

try (CloseableHttpClient httpClient = HttpClients.createDefault()) {

HttpGet httpGet = new HttpGet(url);

try (CloseableHttpResponse response = httpClient.execute(httpGet)) {

BufferedReader reader = new BufferedReader(

new InputStreamReader(response.getEntity().getContent(), "UTF-8"));

StringBuilder result = new StringBuilder();

String line;

while ((line = reader.readLine()) != null) {

result.append(line + "n");

}

return result.toString();

}

}

}

}

需要注意的几个关键点包括:设置合理的超时参数避免长时间阻塞;处理重定向逻辑(默认自动跟随3xx状态码);以及正确解码响应体的字符集(通常为UTF-8),对于复杂的网站可能需要添加请求头伪装成真实浏览器,例如设置User-Agent字段:

httpGet.setHeader("User-Agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36");

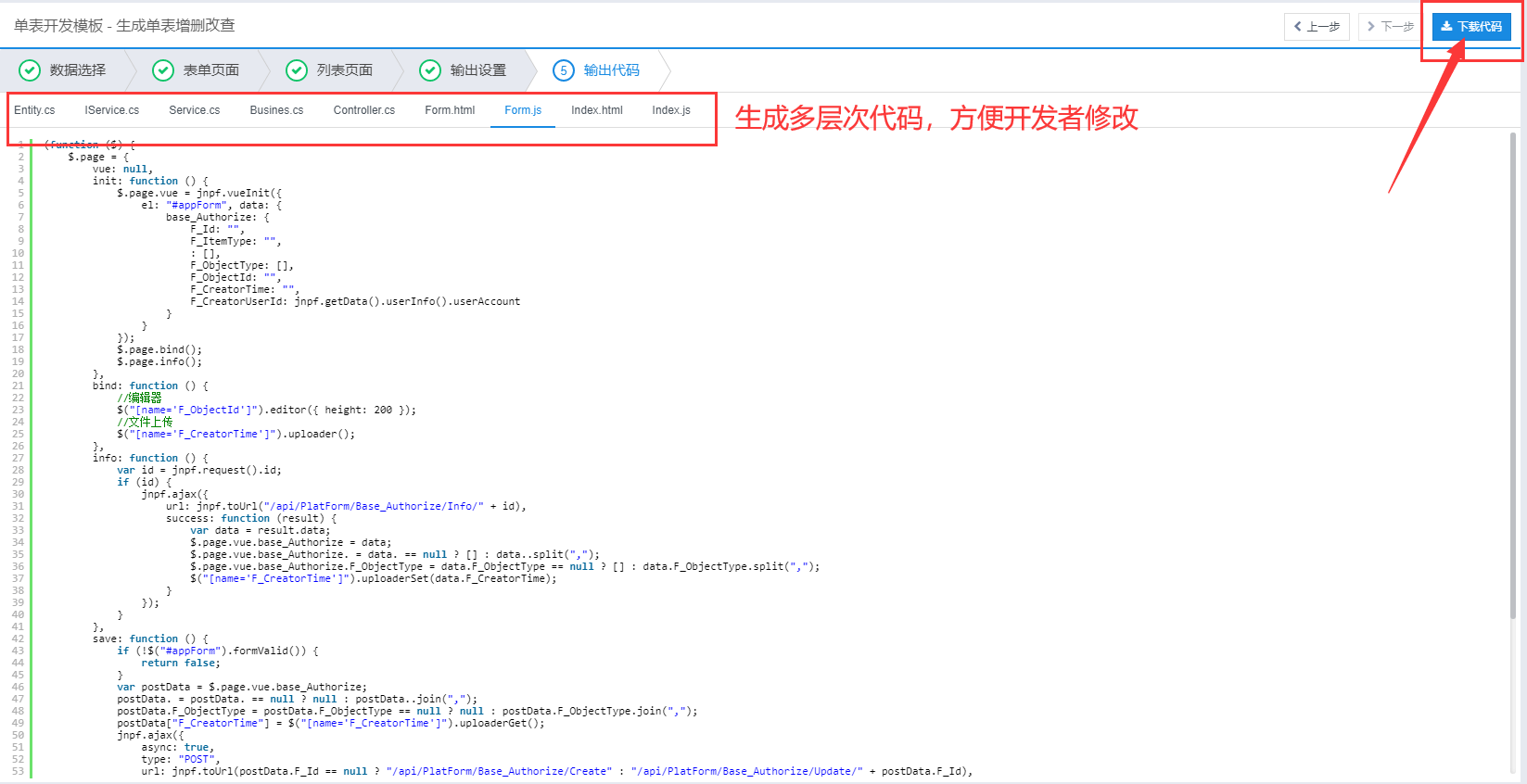

使用Jsoup库进行结构化解析

当需要对HTML进行标签级操作时,Jsoup是一个强大的工具,它不仅能获取完整文档,还能方便地提取特定元素及其属性,以下是结合连接池与Jsoup的使用示例:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import java.net.URI;

public class JsoupExample {

public static Document parseWebPage(String targetUrl) throws Exception {

return Jsoup.connect(targetUrl)

.userAgent("Custom User Agent") // 可选的反爬策略

.timeout(10000) // 设置10秒超时

.get(); // 同步获取文档对象

}

// 使用方法:Document doc = parseWebPage("https://example.com");

// System.out.println(doc.html()); // 输出完整HTML

}

该库的优势在于提供了类似jQuery的选择器语法,例如doc.select("div#main > a")可以精准定位到指定区域的链接元素,同时会自动修正格式错误的HTML片段,确保生成标准兼容的DOM树结构。

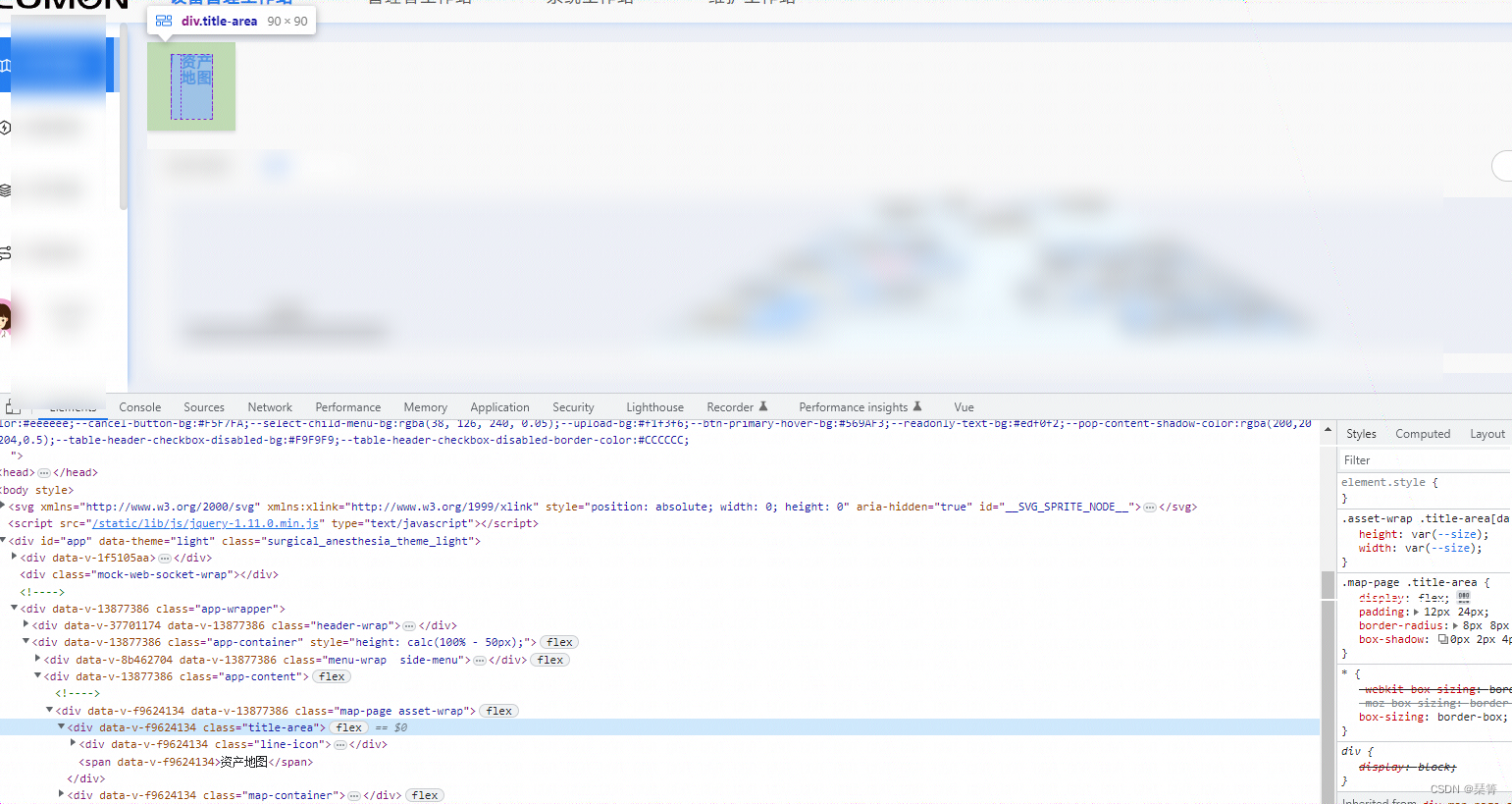

Selenium实现动态渲染捕获

针对单页应用(SPA)或依赖JavaScript动态生成内容的页面,必须采用浏览器自动化测试框架Selenium,这种方式会真正启动一个WebDriver实例,完整执行页面所有的脚本逻辑后再提取源代码,基本流程如下:

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.chrome.ChromeOptions;

public class BrowserRenderer {

public static String renderDynamicPage(String pageUrl) {

System.setProperty("webdriver.chrome.driver", "/path/to/chromedriver");

ChromeOptions options = new ChromeOptions();

options.addArguments("--headless", "--disable-gpu"); // 无头模式节省资源

try (WebDriver driver = new ChromeDriver(options)) {

driver.get(pageUrl);

Thread.sleep(3000); // 根据实际加载速度调整等待时间

return driver.getPageSource(); // 获取执行后的完整HTML

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

return null;

}

}

}

需要注意的是,此方案性能开销较大,适合处理少量必须动态加载的页面,建议配合显式等待机制替代硬编码休眠,例如通过WebElement的visibilityOfElementLocatedBy条件判断来触发后续操作。

不同方案对比表

| 特性 | HttpClient方案 | Jsoup方案 | Selenium方案 |

|---|---|---|---|

| 适用场景 | 静态页面抓取 | 带简单解析需求的抓取 | 动态渲染页面捕获 |

| 性能消耗 | 低(纯网络IO) | 中等(含基础解析) | 高(启动完整浏览器进程) |

| JavaScript支持 | |||

| API友好度 | ️(标准HTTP协议栈) | ️(类jQuery语法) | ️(WebDriver标准) |

| 反爬应对能力 | 需手动构造请求头 | 同左 | 可模拟人工操作行为 |

异常处理最佳实践

无论采用哪种方式,都应该考虑以下容错机制:检查HTTP状态码是否为200;捕获网络层面的SocketTimeoutException;验证返回内容的MIME类型是否为text/html;对于大文件采用流式处理防止内存溢出,例如在HttpClient实现中增加校验逻辑:

if (response.getStatusLine().getStatusCode() != 200) {

throw new IllegalStateException("Failed to fetch page, HTTP code: " + response.getStatusLine().getStatusCode());

}

String contentType = response.getEntity().getContentType().getValue();

if (!contentType.startsWith("text/html")) {

throw new UnsupportedOperationException("Target resource is not an HTML document");

}

相关问答FAQs

Q1:为什么用HttpClient获取的HTML有时不完整?

A:可能原因包括服务器分块传输未完全接收、压缩编码未解压(如gzip)、或者页面本身由多个帧组成,解决方案是启用自动解压缩支持,并确保读取完所有数据块,在HttpClient中可通过requestConfig.setExpectContinueEnabled(false)禁用期待继续握手机制提高效率。

Q2:Jsoup能否修改原始HTML后重新提交?

A:完全可以,通过doc.outputSettings().syntax(Document.OutputSettings.Syntax.html).charset("UTF-8")配置输出规范,调用doc.html()可获得格式化后的字符串用于POST请求体,但注意表单字段的enctype属性会影响服务器端的解析方式,建议保持application/x-www-form-urlencoded标准