上一篇

spark每台物理机可以启动

- 物理机

- 2025-07-12

- 2

park每台物理机可启动多个Executor,具体数量依集群配置、资源状况及任务

Spark中,每台物理机可以启动的组件及相关内容如下:

Master节点

- 功能:负责接收用户提交的作业,将作业分解成多个Task,并将Task分发给Worker节点,最后收集所有Worker节点的结果并返回给用户。

- 启动方式:在一台机器上执行

$SPARK_HOME/sbin/start-master.sh命令即可启动Master节点。

Worker节点

- 功能:接收Master节点分配的Task,将Task转换为一个或多个Executor,然后由Executor执行Task,并将结果返回给Master节点。

- 启动方式:在每台机器上执行

$SPARK_HOME/bin/spark-class org.apache.spark.deploy.worker.Worker spark://<master-hostname>:<master-port>命令,其中<master-hostname>和<master-port>需要替换为实际的Master节点的主机名和端口号。

Driver进程

- 功能:负责作业的调度,向资源管理器为Executor申请资源,向Executor分发Task,并收集Task处理完成的结果。

- 启动方式:可以通过

spark-shell命令启动,此时Driver进程会在当前机器上启动;也可以通过spark-submit命令提交应用程序,指定--deploy-mode为client或cluster,若为client模式,Driver进程在提交应用程序的客户端机器上启动,若为cluster模式,Driver进程在集群上的Work Node启动。

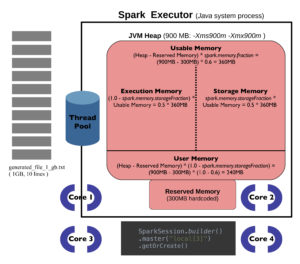

Executor进程

- 功能:负责执行Task,并与Driver进程交互,汇报执行结果。

- 启动方式:当Driver进程向资源管理器申请到资源后,会在相应的Worker节点上启动Executor进程,一个Spark应用中一般有多个Executor,同一台物理机可以有多个Executor。

以下是不同模式下各组件在每台物理机上的启动情况归纳表格:

| 模式 | Master节点 | Worker节点 | Driver进程 | Executor进程 |

|---|---|---|---|---|

| Standalone模式 | 1台(整个集群中) | 多台(根据集群规模) | 在提交作业的机器上或集群中的Work Node上(取决于部署模式) | 在各个Worker节点上,可多个 |

| YARN模式 | 无需单独启动(由YARN资源管理器管理) | 无需单独启动(由YARN资源管理器管理) | 在提交作业的机器上或集群中的NodeManager上(取决于部署模式) | 在各个NodeManager管理的容器中,可多个 |

| Mesos模式 | 无需单独启动(由Mesos资源管理器管理) | 无需单独启动(由Mesos资源管理器管理) | 在提交作业的机器上或集群中的Mesos节点上(取决于部署模式) | 在各个Mesos节点管理的容器中,可多个 |

| Local模式 | 无需启动 | 无需启动 | 在本地机器上 | 在本地机器上,可多个(根据配置) |

FAQs

问题1:在Spark Standalone模式中,如果一台物理机既作为Master节点又作为Worker节点,会对性能有什么影响?

回答:在这种情况下,该物理机既要承担Master节点的任务调度和管理职责,又要作为Worker节点执行任务,这可能会导致资源竞争,例如CPU、内存等资源被Master和Worker进程同时占用,从而影响整体性能,尤其是当作业规模较大时,可能会出现性能瓶颈,因为Master节点的调度决策可能会受到自身负载的影响,而Worker节点的执行效率也会因资源分配不足而降低。

问题2:在Spark应用中,如何控制每台物理机上启动的Executor数量?

回答:可以通过设置spark.executor.instances参数来控制每台物理机上启动的Executor数量,该参数可以在提交应用程序时通过--conf spark.executor.instances=<num>命令行参数指定,也可以在Spark配置文件中进行设置,还可以结合spark.executor.cores和spark.executor.memory等参数来合理分配资源,以确保每个Executor都能获得足够的CPU核心数和内存资源,从而提高应用